人工智能发展何时突破桎梏?

最近某品牌汽车在样车测试时发生事故,造成了巨大的人员和财产损失,第一时间上了新闻头条。同时还有自动驾驶的老生常谈。自动驾驶安全吗?自动驾驶该不该开?在自动驾驶的外壳下,人工智能能否有道德判断作为问题的核心,也很难有定论。

“电车难题”人工智能面临道德困境

美国麻省理工学院设计了一个名为道德机器的网站。网站设计了各种失控汽车的场景供观众选择。通过收集300万用户的反馈,道德机器发现人们更倾向于让自动驾驶汽车自毁以保护更多人的生命,但希望他们的汽车不具备这一功能。这个结论和文化习俗无关。这是人类共同的选择,也符合社会的普遍认知。人们希望牺牲少数人的生命来换取更多人的生命。但这是违背规律的,因为人的生命本身是无法比较和量化的。

这是自动驾驶不可避免的道德问题。一方面,如果允许AI失控决策,根据权责一体化的规定,意味着AI或者背后的自动驾驶公司要对决策负责。另一方面,如果不允许AI做决策,就不能称之为自动驾驶3354,因为自动驾驶汽车的定义是能够感知其环境并在没有人类操作的情况下导航和驾驶的汽车。

自动驾驶遇到的“电车问题”只是人工智能行业遇到困难的一个缩影。随着科技的进步和大数据产业的发展,人工智能模型变得更加成熟,但在涉及道德、意识等人类问题时却处于尴尬的境地。根据人工智能的“奇点”理论,人工智能最终会在理性和感性上超越人类,但人类对人工智能的安全性一直有一种“弗兰肯斯坦情结”,一般人类在心理上无法接受与非生物机器共情。

今年6月初,谷歌2021年推出的对话应用语言模型LaMDA被其负责工程师之一的Lemoy“意识到”。他认为LaMDA model是一个有自我意识的“人”,能够感知世界,具有七八岁孩子的智力。Lemoy说,LaMDA model不仅把自己当成一个人,还会争取自己作为一个人的权利,并积极捍卫。事件爆发后,很多网友支持Lemoy,认为人工智能的奇点已经到来,认为人工智能已经变得有意识有灵魂,可以像人一样独立思考。

判断价值人工智能的爆炸雷区

人工智能是否有道德,即人工智能是否应该有价值判断?

如果你认为人工智能是道德的,说明人工智能可以摆脱人的意志,独立评价事件或事物。这在技术层面并不难实现。通过大量的数据“喂养”,人工智能可以将事件或事物数字化,并根据深度学习形成的一套“判断标准”进行衡量。本文的LaMDA模型也是如此。但实际上,LaMDA模型只是一个响应机器。著名的机器学习和神经网络专家加里马库斯(Gary Marcus)说,“LaMDA只是从人类语料库中提取单词,然后匹配你的问题。”从这个角度来看,人工智能所谓的“道德”只是对事件或事物的一种回应,并不能深刻理解什么是道德评价及其意义。

例如,不同的人工智能模型对同一种情况有不同的处理方式。还是以自动驾驶为例,用同样的方式冲向同一个桩桶,结果却完全不同。有的直接碰撞,有的躲避。这能上升到道德层面吗?显然不是,甚至两个模型没有区别,因为基于不同概念和需求设计的模型是特殊的。前者认为这种情况属于驾驶员操作范畴,不需要干预;后者认为应该介入。

让我们后退一步。假设人工智能具有类似人类的意识,能够独立思考,是否意味着我们可以寄希望于它能够解决道德问题?答案是否定的,简单来说,人类自身无法解决的道德问题,不能指望没有“人性”概念的数字来解决。

从这个角度来说,发展人工智能的价值判断不存在道德问题。更重要的是分析为什么需要道德评价。道德评价的本质是得到一个结果,并指导后续行为。记者认为,在人工智能的归责上,应将人工智能分为决策系统和执行系统,并在相应的系统中引入“责任人”制度。

从决策的角度来说,虽然从法律的角度来说惩罚行为的思想并不惩罚,只是针对自然人。但目前人工智能的“思想”是可以通过数据来表达的,所以从决策层面来说,人工智能还是需要控制的。人工智能的“思维”存在错误。原因是训练算法的数据存在问题,即人工智能学习社会问题并加以应用。比如美国的电商品牌亚马逊,在招聘员工的时候用人工智能算法对候选人的简历进行初步筛选,结果更多的是男性,因为工程师用之前被亚马逊雇佣过的员工的简历来训练算法,而亚马逊的男性员工更多。这样一来,这种算法使得亚马逊的简历筛选算法更加男性化,造成了算法的“性别歧视”。记者认为,如果法律结果是由算法和训练数据造成的,那么负责算法设计或训练的责任主体应该承担责任。

从行为的角度来看,即使人工智能在行为执行上已经可以媲美甚至超越人类,但在法律层面,人工智能仍然被视为一种物而非权利和能力的主体。这意味着现行法律否认人工智能可以独立承担法律责任。本质上是因为人工智能无法对自己的行为负责。设立“责任人”制度类似于法人组织的法定代表人制度,由特定自然人承担行为所产生的责任。通过区分“思考”和“行动”,可以在归责上更加细化,保证责任有效,不影响人工智能产业发展的积极性。在当前民事领域,人工智能产品侵权适用产品责任,强调对开发者、生产者、销售者的责任。

近年来,我国陆续发布《新一代人工智能治理原则》《新一代人工智能》

能伦理规范》等政策文件,明确提出八项原则,强调将伦理道德融入人工智能全生命周期,从原则性角度维护人工智能行业的健康发展。有关人士表示,国家科技伦理委员会人工智能分委会正在研究起草人工智能伦理高风险清单,以更好地推动人工智能科研活动的伦理监管工作。相信随着更多法律规范的出台,人工智能的应用道德问题一定能得到极大缓解。小贴士

人工智能都有哪些梗?

电车难题:“电车难题(TrolleyProblem)”是伦理学领域最为知名的思想实验之一,最早是由哲学家菲利帕·福特(PhilippaFoot)于1967年发表的《堕胎问题和教条双重影响》论文中提出来的。大致内容是假设在一个电车轨道上绑了5个人,备用轨道上绑了1个人,有一辆失控的电车飞速驶来。而你身边正好有一个摇杆,你可以推动摇杆来让电车驶入备用轨道,杀死那1个人,救下5个人;你也可以什么都不做,杀死5个人,救下1个人。此类伦理道德困境问题被称为“电车难题”。

人工智能“奇点”论:最先将“奇点”引入人工智能领域的是美国未来学家雷·库兹韦尔。在他的《奇点临近》《人工智能的未来》两本书中,将二者结合,他用“奇点”作为隐喻,描述的是当人工智能的能力超越人类的某个时空阶段。而当人工智能跨越了这个“奇点”之后,一切我们习以为常的传统、认识、理念、常识将不复存在,技术的加速发展会导致一个“失控效应”,人工智能将超越人类智能的潜力和控制,迅速改变人类文明。

弗兰肯斯坦情结:源于小说家阿西莫夫,指人类惧怕机器的心理状态。弗兰肯斯坦是1818年玛丽·雪莱创作的一本叫做《弗兰肯斯坦——现代普罗米修斯的故事》的小说中的主人公,他制造出了一个类人生物,但他也因此被反噬。“弗兰肯斯坦”现被用来指代人类制造的怪物。在现在的文学、电影等作品中,“弗兰肯斯坦情结”常暗指人工智能征服人类并开始管理这个世界。

-

-

改了!618前淘宝改名:手机淘宝正式更名为淘宝

终于改了!618前,手机淘宝正式改名为淘宝。记者发现,目前在AppStore等各大应用商店里,原来手机淘宝APP的名称已经变成了淘宝。据悉,这是

2021-05-27 16:54

-

-

天猫618预售火爆,犀牛工厂订单排到下个月

太火爆了,工厂订单已经排到了下个月!5月26日,犀牛智造计划排产总监陈哲发了一则朋友圈。天猫618预售启动后,一批尝试即卖即产服饰商家销

2021-05-27 16:55

-

-

造车“二进宫” 美的再陷多元化怪圈?

为提振投资者信心,美的近来真的很努力。对于意兴阑珊的资本市场,这家家电巨头接连打出了回购牌、增持牌以及王炸——进军新能源汽车产

2021-06-01 10:42

-

-

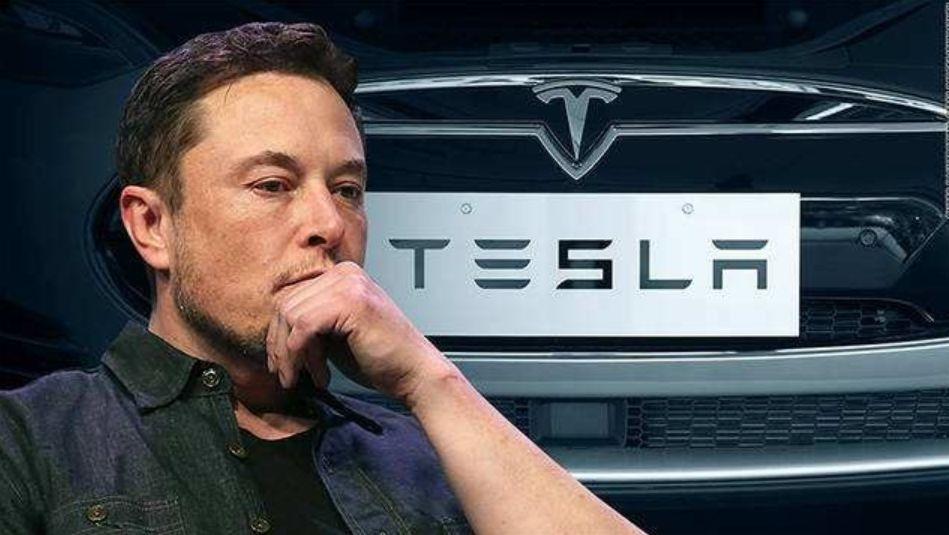

特斯拉深陷信任危机 新能源产品供求双方须心怀足够敬畏

日前,有网友向工信部提交信件表示:把动能回收功能与加速踏板相结合,让加速踏板具有明显制动效果这一设计违背常理、违背汽车百年驾驶习惯

2021-06-01 14:35

-

-

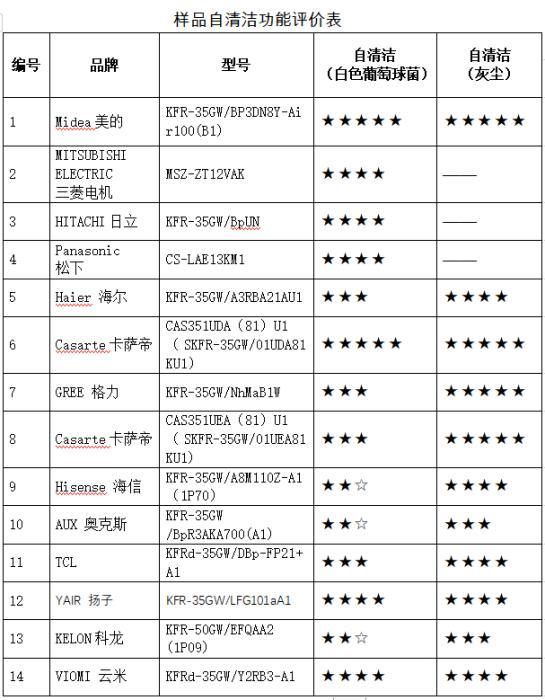

中消协测评:奥克斯、科龙空调样机自清洁细菌表现较差

如今消费者选购空调时,除了基本的温度调控功能,更多人倾向关注附加了自清洁、除菌、新风、净化、舒适等健康理念和功能的产品,但这些

2021-06-04 14:43

蔚蓝财经

蔚蓝财经